벡터의 크기

벡터가 원점 벡터와의 거리는 무엇일까?

Norm이라고 한다.

대표적으로 2가지가 있다.

$ l_{2} norm $ $ \parallel x\parallel_{2} = \sqrt { \sum_{i=1}^n x_{i}^{2} }$

$ l_{1} norm $ $ \parallel x\parallel_{1} = \sum_{i=1}^n |x_{i}| $

$ \parallel x \parallel $ 은 원점으로부터 벡터의 길이를 말한다.

$ l_{1} norm $ 은 맨하탄 디스턴스와 같이 생각할 수 있다.

거리는 유니크하게 정의되는 것이아니라 다양하게 정의될 수 있음.

직교성(Orthogonality)

벡터 두개($ x, y $)가 있을 때, 직교한다는 것은 $ \vec{x} \cdot \vec{y} = x^Ty = 0 $이다 (첫번째 벡터 transpose).

orthonormal 하다는 것은 직교하면서 크기가 유닛하다는 것이다.

각각의 벡터의 크기가 1일때.

$ x^Ty= 0 $ 이고 $ \parallel x\parallel_{2} = \parallel y \parallel_{2} =1$ 이다.

두 벡터 사이 각도

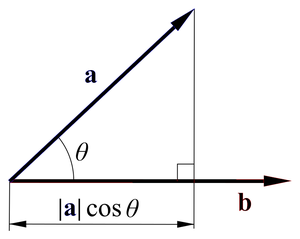

내적은 다음과 같다.

벡터에는 방향이 있으므로 방향이 일치하는 만큼만 곱한다.

두 벡터의 방향이 같으면 두 벡터의 크기를 그냥 곱한다.

두 벡터가 이루는 각이 90도 일 땐, 일치하는 정도가 전혀 없기 때문에 내적의 값은 0이다.

내적은 한 벡터를 다른 벡터로 정사영 시켜서, 그 벡터의 크기를 곱한다.

내적의 개념을 활용하여 각도를 구할 수 있다.

$ \cos \theta = \frac { x^Ty} { \parallel x \parallel \cdot \parallel y \parallel } $

벡터의 내적의 결과값은 벡터가 아닌 스칼라이다.

위키독스

온라인 책을 제작 공유하는 플랫폼 서비스

wikidocs.net

'머신러닝과 딥러닝' 카테고리의 다른 글

| 최적화 문제 풀기 (0) | 2019.12.30 |

|---|---|

| 최적화와 볼록최적화(Optimization and Convex Optimization) (0) | 2019.12.30 |

| 선형변환과 행렬 (0) | 2019.12.30 |

| Doc2Vec 공간의 이해 (0) | 2019.12.29 |

| 행렬식의 의미 (0) | 2019.12.23 |